Буферы передачи и приема что это такое

Высокий пинг в игре? Лезем в настройки сетевой карты. Часть 2

В этой статье будут рассмотрены настройки сетевой платы, которые теоретически могут снизить высокий пинг в игре, победить лаги и как то повлиять на fps. Из первой части мы поняли, что динамичные многопользовательские онлайн игры используют протокол UDP, поэтому при ее настройке будем это учитывать. Обращаю внимание, что так сбить высокий пинг и убрать лаги получится, если у вас слабый компьютер и "хорошая" сетевуха или наоборот. Играясь с этими параметрами, нужно пробовать переложить нагрузку на то железо, которое у вас не испытывает проблем с производительностью. И итогом всей этой битвы и мучений, может быть станет выигрыш в несколько миллисекунд.Почему пинг высокий и как его понизить?

В первой части (из серии статей) мы пробовали победить высокую сетевую задержку с помощью настройки MTU. В этой рассмотрим и узнаем, какие настройки сетевой платы пригодятся любителям игр. Jumbo Frame - Jumbo Packet - Большой кадр:

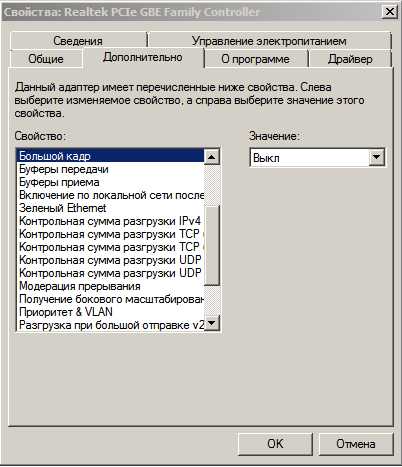

Jumbo Frame - Jumbo Packet - Большой кадр:

Использование этого параметра, наверно только гипотетически поможет снизить пинг в играх и наверно какая то выгода будет во время долгих массовых сражений и осад, когда в одну секунду генерируется очень приличное количество трафика. Дело в том, что использование больших кадров должно быть настроено у всех участников взаимодействия, как у клиента и сервера, так и транзитных узлов. Но за пределами вашего провайдера (да и у самого провайдера) mtu всегда примерно равен 1,5 кб плюс\минус десятки байтов. Если использовать его в локальных сетях (где можно точно проконтролировать эту настройку у всех), то там пинг зачастую и так достаточно низкий.

В чем плюс? Если использовать 9 кб у всех участников, вместо 1,5 кб, то для обсчета одного кадра потребуется в 6 раз реже задействовать процессор. Что должно лучше сказаться на прибавке фпс.

В чем минус? Если использовать его только на клиенте, при отсылке на остальных узлах пакет будет фрагментирован, в лучшем случаем на 6 частей, а при mtu <1500 может и на более. Которые в итоге будут переданы на каждый последующий узел, и где он должен попасть на сервер без потерь и корректно собран в один целый. В век высоких технологий, сбор и разбиение проходят быстро, но тем не менее, не всегда возможно предсказать насколько будет загружено оборудование обрабатывающее эти фрагменты. И эта фрагментация и загрузка транзитных узлов и может привести к росту пинга.

Значение: Выкл.

Checksum Offload - IPv4 Checksum Offload - Контрольная сумма разгрузки IPv4:

Если ваш адаптер имеет такую функцию, то включите ее. Это позволит освободить центральный процессор от расчета и проверки контрольных сумм для отправляемых и принимаемых пакетов. Что должно положительно сказаться на фпс в игре. Но бывают и обратные случаи, когда отключение это функции позволяет улучшить пинг и снизить лаги. Так что, попробуйте поиграться с этим параметром, при наличии лагом и скачущего пинга.

Значение: Вкл для Tx и Rx

Speed & Duplex - Link Speed/Duplex Mode - Скорость и дуплекс

Тут нужно проверить, что у вас стоит 10\100\1 Гб дуплекс. При использовании режима полудуплекс, пинг становится выше.

Можете в этом убедиться, переключив режимы и пингануть любой сервер.

Значение: Дуплексный режим

Flow Control - Управление потоком

Данная настройка призвана решать проблему, когда входящий трафик приходит с такой скоростью, что создает угрозу переполнения буфера на сетевом оборудовании и тогда источнику отправляется команда, чтобы он выждал паузу и снова повторил отправку данных, через какой-то промежуток времени. Если же такой команды не послать, то из-за перегрузки часть данных просто потеряется, т.е. в игре это гарантированный лаг. Вроде бы хорошая и правильная и нужная функция, но только для тех кто скачивает большие объемы. В играх как правило трафик приходит не в таком интенсивном режиме. Если же кадр паузы будет послан, то одномоментно увеличится пинг. Т.е. если у вас в играх частые лаги и высокая сетевая задержка, попробуйте поиграться с этим параметром.

Значение: Выключить

Transmit Buffers - Буферы передачи / Receive Buffers - Буферы приема

Зачастую буфер приема имеет в настройках больший размер, так как трафика мы скачиваем больше, чем отдаем. Здесь главное придерживаться правила, что буфер приема минимум должен быть равен 100*mtu. Если mtu=1500 байт, то размер буфера должен быть не меньше 147 кб. Если будет меньше, то в массовых событиях в игре, с генерацией большого количества трафика, возможна потеря пакетов. Прямого влияние на пинг, данные настройки не оказывают. Скорее это касается лагов. Так что убедитесь, что данные параметры выставлены по умолчанию и не имеют слишком малого размера.

Для буфера передачи вполне подойдет заводское значение. Вряд ли на клиенте в игре можно на генерировать столько трафика, чтобы пакеты при этом не поместились в буфер.

TCP/UDP Checksum Offload IPv4/IPv6 - Контрольная сумма разгрузки TCP/UDP IPv4/IPv6

Чтобы узнать, дошел ли пакет до адресата целый и без ошибок, для проверки на другой стороне в него добавляют контрольную сумму, которая рассчитывается на основании данных пакета. Если у вас имеется данная функция в настройке, попробуйте ее включить для обоих типов трафика. Таким образом все вычисления будет проводить не процессор, а сетевой адаптер, что в итоге должно положительно сказаться на фпс в игре.

Значение: Rx & Tx Включить

Interrupt Moderation - Модерация прерывания

При получении одного пакета, сетевой адаптер вызывает прерывание. Когда идет интенсивный обмен трафиком такие прерывания создают нагрузку на процессор. И чтобы снизить ее, придумали накапливать события в течении какого-то времени и после этого вызывать прерывание (IRQ). Таким образом реже задействуя процессор. У такого способа есть свои плюсы, описанный ранее и так же можно сказать, что вся прелесть этой функции раскрывается для тех, кто много качает.

Из минусов, чтобы пакет был обработан, он ожидает, пока отработает таймер. Это то и добавляет пинга в игре.

Значение: Выключить Receive Side Scaling - RSS - Получение бокового масштабирования

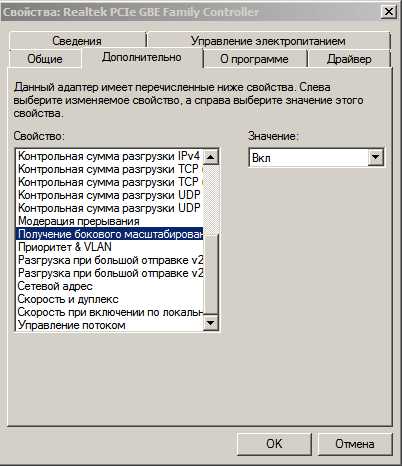

Receive Side Scaling - RSS - Получение бокового масштабирования

Это интересный и нужный механизм для обладателей многоядерных процессоров. При включении его, пакеты делятся по потокам и каждый поток может обрабатывать отдельный процессор. Т.е. задействуются все ядра, что должно положительно сказаться на производительности в целом и на пинге в частности. Если эта функция выключена, весь трафик обрабатывается одним ядром.

Но все эти преимущества будут, если драйвер написан без ошибок. Иначе, бывают случаи, когда после включения начинаются проблемы и деградация производительности. Если вы впервые включаете его, внимательно понаблюдайте за сетью какое-то время.

Значение: Включить

Large Send Offload IPv4/IPv6 - Giant Send Offload - Разгрузка при большой отправке IPv4/IPv6

Фрагментацией пакетов данных при отправке будет заниматься сетевой адаптер, а не программное обеспечение. В идеале аппаратное фрагментирование проходит быстрее, меньше задействуется процессор, что в итоге для любителей игр должно положительно сказаться на пинге и фпс.

Есть еще настройка Large Send Offload v2, она выполняет ту же функцию, только для пакетов покрупнее. Иногда ее включение плохо влияет на производительность сети.

Значение: Включить

И в заключении коротко про пинг и представленные настройки

Некоторые параметры у разных производителей называются по-разному. Если вы у себя их не нашли, значит производитель не предусмотрел их настройку.

Вы должны понимать, что рекомендуемые здесь значения ориентированы на снижение пинга. Поэтому для любителей торрентов, данные параметры могут негативно сказаться на производительности и вызвать повышенную нагрузку на систему.

Все манипуляции с настройками сетевого адаптера обязательно проводите поэтапно. Не стоит все увиденое применять на практике сразу и одномоментно. На разных сетевых платах, эти настройки могут показать разное поведение.

Так же конечный результат зависит и от прямоты рук программистов, которые писали драйвера.

Надеюсь эта статья открыла что то новое для вас и помогла, хоть чуть-чуть, снизить высокий пинг в любимой игре.

Продолжение тут: третья и четвертая части

- Подробности

- Опубликовано: 01.09.2016 г.

Сетевые адаптеры настройки производительности | Microsoft Docs

- Время чтения: 11 мин

В этой статье

Область применения: Windows Server 2019, Windows Server 2016, Windows Server (Semi-Annual Channel)Applies to: Windows Server 2019, Windows Server 2016, Windows Server (Semi-Annual Channel)

Используйте сведения в этом разделе для настройки сетевых адаптеров производительности для компьютеров под управлением Windows Server 2016 и более поздних версий.Use the information in this topic to tune the performance network adapters for computers that are running Windows Server 2016 and later versions. Если сетевые адаптеры предоставляют параметры настройки, эти параметры можно использовать для оптимизации пропускной способности сети и использования ресурсов.If your network adapters provide tuning options, you can use these options to optimize network throughput and resource usage.

Правильные параметры настройки для сетевых адаптеров зависят от следующих переменных.The correct tuning settings for your network adapters depend on the following variables:

- сетевой адаптер и набор его функций;The network adapter and its feature set

- Тип рабочей нагрузки, выполняемой серверомThe type of workload that the server performs

- аппаратные и программные ресурсы сервера;The server hardware and software resources

- задачи настройки сервера.Your performance goals for the server

В следующих разделах описывается ряд параметров настройки производительности.The following sections describe some of your performance tuning options.

Включение функций разгрузкиEnabling offload features

Включение функций разгрузки на сетевом адаптере обычно имеет положительный эффект.Turning on network adapter offload features is usually beneficial. Однако сетевой адаптер может оказаться недостаточно мощным для обработки возможностей разгрузки с высокой пропускной способностью.However, the network adapter might not be powerful enough to handle the offload capabilities with high throughput.

Важно!

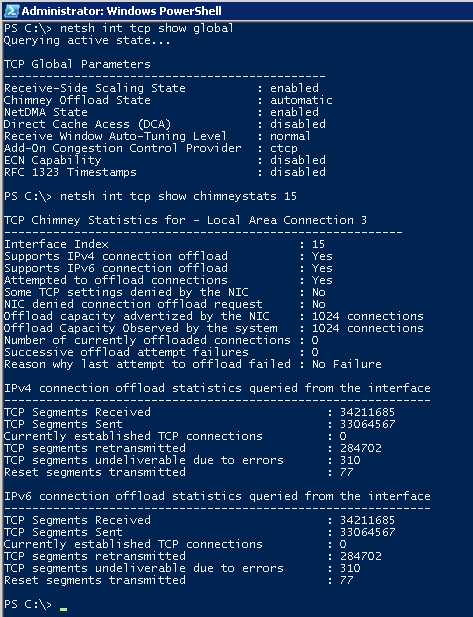

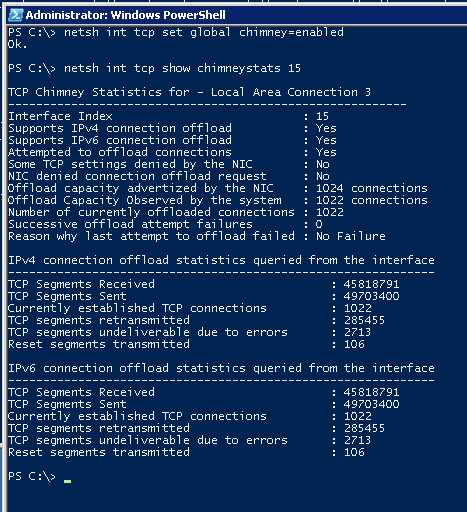

Не используйте разгрузку задач IPSec функции разгрузки или разгрузку TCP Chimney.Do not use the offload features IPsec Task Offload or TCP Chimney Offload. Эти технологии являются устаревшими в Windows Server 2016 и могут негативно сказаться на производительности сервера и сети.These technologies are deprecated in Windows Server 2016, and might adversely affect server and networking performance. Кроме того, эти технологии могут не поддерживаться корпорацией Майкрософт в будущем.In addition, these technologies might not be supported by Microsoft in the future.

Например, рассмотрим сетевой адаптер с ограниченными аппаратными ресурсами.For example, consider a network adapter that has limited hardware resources. В этом случае включение возможности разгрузки сегментации может снизить максимальную устойчивую пропускную способность адаптера.In that case, enabling segmentation offload features might reduce the maximum sustainable throughput of the adapter. Однако если приемлема пропускная способность, следует включить функции сегментирования разгрузки.However, if the reduced throughput is acceptable, you should go ahead an enable the segmentation offload features.

Примечание

Для некоторых сетевых адаптеров требуется включить разгрузку компонентов независимо для путей отправки и получения.Some network adapters require you to enable offload features independently for the send and receive paths.

Включение масштабирования на стороне приема (RSS) для веб-серверовEnabling receive-side scaling (RSS) for web servers

RSS способно повысить веб-масштабируемость и производительность, когда число сетевых адаптеров меньше количества логических процессоров на сервере.RSS can improve web scalability and performance when there are fewer network adapters than logical processors on the server. Когда весь веб-трафик проходит через сетевые адаптеры, поддерживающие RSS, сервер может обрабатывать входящие веб-запросы с разных соединений одновременно на разных процессорах.When all the web traffic is going through the RSS-capable network adapters, the server can process incoming web requests from different connections simultaneously across different CPUs.

Важно!

Избегайте использования сетевых адаптеров, отличных от RSS, и сетевых адаптеров, поддерживающих RSS, на одном сервере.Avoid using both non-RSS network adapters and RSS-capable network adapters on the same server. Из-за логики распределения нагрузки в RSS и протоколе HTTP, производительность может быть значительно снижена, если сетевой адаптер, не поддерживающий RSS, принимает веб-трафик на сервере с одним или несколькими сетевыми адаптерами, поддерживающими RSS.Because of the load distribution logic in RSS and Hypertext Transfer Protocol (HTTP), performance might be severely degraded if a non-RSS-capable network adapter accepts web traffic on a server that has one or more RSS-capable network adapters. В этом случае необходимо использовать сетевые адаптеры, поддерживающие RSS, или отключить RSS на вкладке Дополнительные свойства в свойствах сетевого адаптера.In this circumstance, you should use RSS-capable network adapters or disable RSS on the network adapter properties Advanced Properties tab.

Чтобы определить, поддерживает ли сетевой адаптер RSS, можно просмотреть сведения RSS на вкладке Дополнительные свойства в свойствах сетевого адаптера.To determine whether a network adapter is RSS-capable, you can view the RSS information on the network adapter properties Advanced Properties tab.

Профили RSS и очереди RSSRSS Profiles and RSS Queues

Стандартный профиль RSS по умолчанию — нумастатик, который отличается от используемого по умолчанию предыдущих версий Windows.The default RSS predefined profile is NUMAStatic, which differs from the default that the previous versions of Windows used. Прежде чем приступить к использованию профилей RSS, ознакомьтесь с доступными профилями, чтобы понять, когда они полезны и как они применяются к сетевой среде и оборудованию.Before you start using RSS profiles, review the available profiles to understand when they are beneficial and how they apply to your network environment and hardware.

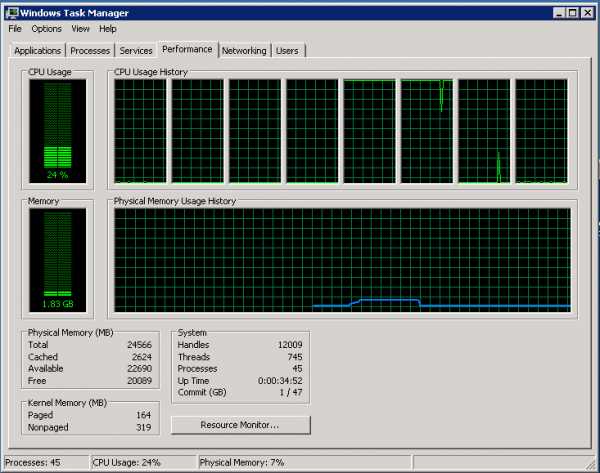

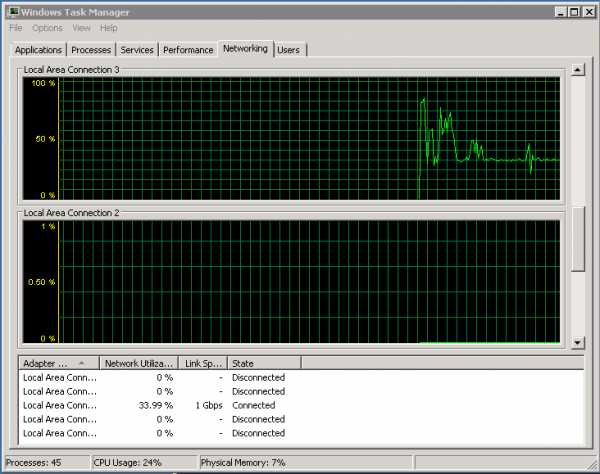

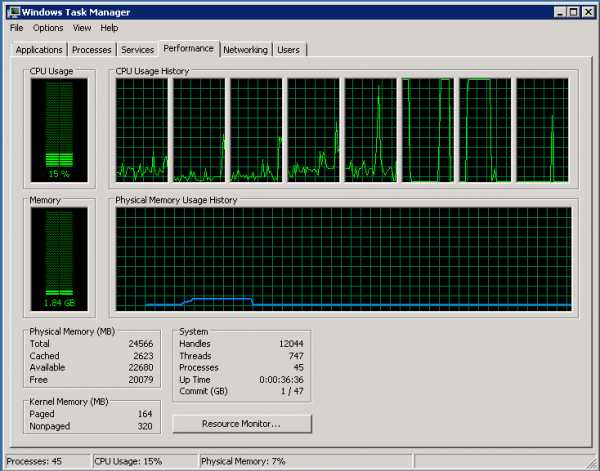

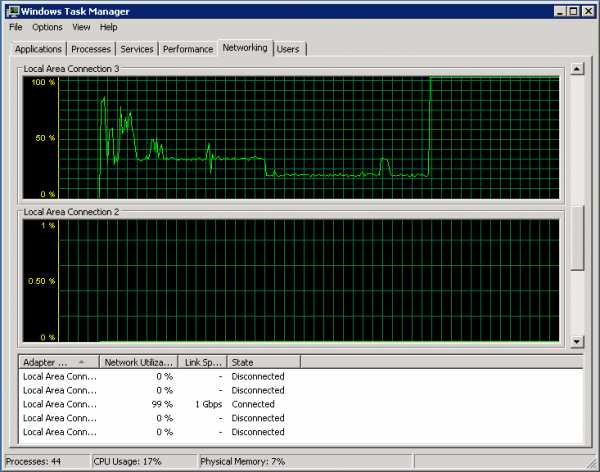

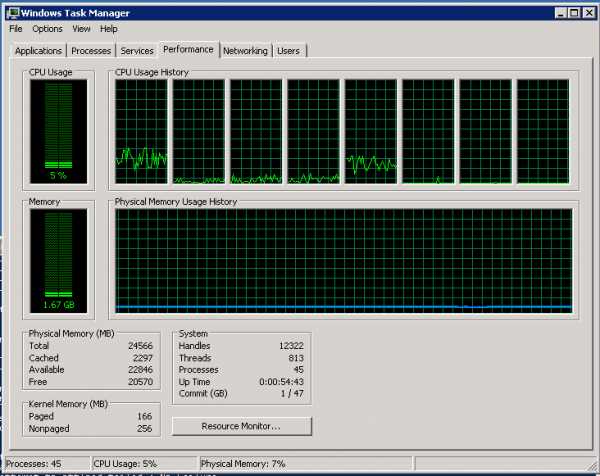

Например, если открыть диспетчер задач и проверить логические процессоры на сервере и они будут недостаточно загружены для приема трафика, можно попробовать увеличить число очередей RSS по умолчанию, равное двум, до максимума, поддерживаемого сетевым адаптером.For example, if you open Task Manager and review the logical processors on your server, and they seem to be underutilized for receive traffic, you can try increasing the number of RSS queues from the default of two to the maximum that your network adapter supports. В используемом сетевом адаптере могут быть параметры для изменения числа очередей RSS в драйвере.Your network adapter might have options to change the number of RSS queues as part of the driver.

Увеличение ресурсов сетевого адаптераIncreasing network adapter resources

Для сетевых адаптеров, позволяющих вручную настраивать ресурсы, такие как буферы приема и отправки, следует увеличить выделенные ресурсы.For network adapters that allow you to manually configure resources such as receive and send buffers, you should increase the allocated resources.

В некоторых сетевых адаптерах устанавливаются небольшие буферы приема для экономии выделенной памяти от узла.Some network adapters set their receive buffers low to conserve allocated memory from the host. Это ведет к потере пакетов и снижению производительности.The low value results in dropped packets and decreased performance. Поэтому для сценариев с интенсивным приемом рекомендуется увеличить буфер приема до максимума.Therefore, for receive-intensive scenarios, we recommend that you increase the receive buffer value to the maximum.

Примечание

Если сетевой адаптер не предоставляет настройки ресурсов вручную, он динамически настраивает ресурсы, или для ресурсов задано фиксированное значение, которое нельзя изменить.If a network adapter does not expose manual resource configuration, either it dynamically configures the resources, or the resources are set to a fixed value that cannot be changed.

Включение контроля прерыванийEnabling interrupt moderation

Для управления прерываниями прерываний некоторые сетевые адаптеры предоставляют различные уровни управления прерываниями, различные параметры объединения буфера (иногда отдельно для буферов отправки и получения) или и то, и другое.To control interrupt moderation, some network adapters expose different interrupt moderation levels, different buffer coalescing parameters (sometimes separately for send and receive buffers), or both.

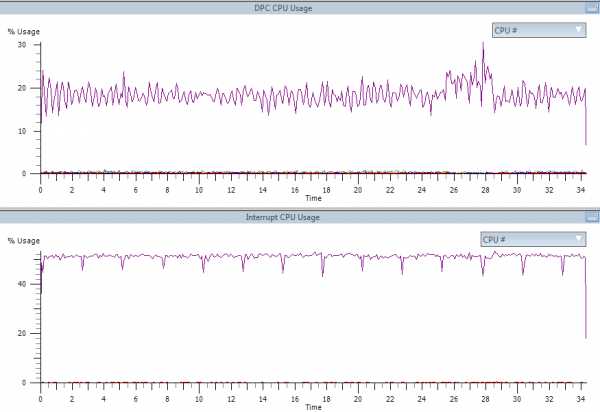

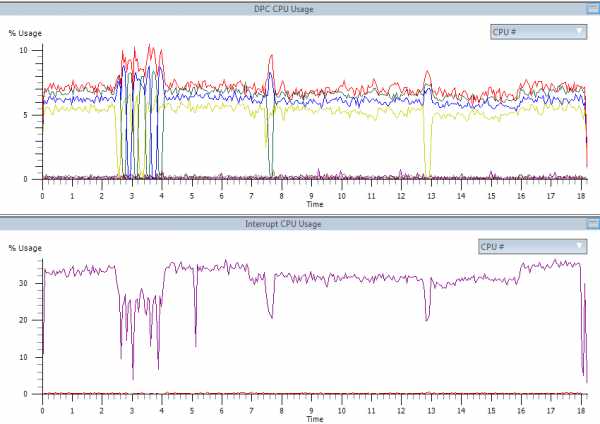

Следует рассмотреть возможность контроля прерываний для рабочих нагрузок, привязанных к ЦП.You should consider interrupt moderation for CPU-bound workloads. При использовании управления прерываниями учитывайте компромисс между экономией ЦП узла и задержкой, а также увеличением экономии ресурсов узла из-за большего количества прерываний и снижения задержки.When using interrupt moderation, consider the trade-off between the host CPU savings and latency versus the increased host CPU savings because of more interrupts and less latency. Если сетевой адаптер не выполняет контроль прерываний, но он предоставляет объединение буферов, можно повысить производительность, увеличив число Объединенных буферов, чтобы освободить больше буферов на отправку или получение.If the network adapter does not perform interrupt moderation, but it does expose buffer coalescing, you can improve performance by increasing the number of coalesced buffers to allow more buffers per send or receive.

Настройка производительности для обработки пакетов с низкой задержкойPerformance tuning for low-latency packet processing

Многие сетевые адаптеры позволяют настраивать параметры для оптимизации системной задержки.Many network adapters provide options to optimize operating system-induced latency. Задержка — это время между обработкой входящего пакета сетевым драйвером и отправкой этого пакета обратно.Latency is the elapsed time between the network driver processing an incoming packet and the network driver sending the packet back. Обычно это время измеряется в микросекундах.This time is usually measured in microseconds. Для сравнения время передачи пакетов на длинные дистанции обычно измеряется в миллисекундах (это на порядок дольше).For comparison, the transmission time for packet transmissions over long distances is usually measured in milliseconds (an order of magnitude larger). Эта настройка не сокращает время прохождения пакета.This tuning will not reduce the time a packet spends in transit.

Ниже приведены некоторые советы по настройке производительности для загруженных сетей, в которых на счету каждая микросекунда.Following are some performance tuning suggestions for microsecond-sensitive networks.

В BIOS компьютера установите значение High Performance (Высокая производительность) и отключите C-состояния.Set the computer BIOS to High Performance, with C-states disabled. Однако имейте в виду, что это зависит от системы и BIOS, и некоторые системы обеспечивают большую производительность, если операционная система управляет электропитанием.However, note that this is system and BIOS dependent, and some systems will provide higher performance if the operating system controls power management. Проверить и настроить параметры управления питанием можно на странице Параметры или с помощью команды powercfg .You can check and adjust your power management settings from Settings or by using the powercfg command. Дополнительные сведения см. в разделе Параметры командной строки Powercfg.For more information, see Powercfg Command-Line Options.

Установите в операционной системе профиль управления электропитанием Высокая производительность.Set the operating system power management profile to High Performance System.

Примечание

Этот параметр не работает должным образом, если BIOS системы имеет значение отключить управление питанием в операционной системе.This setting does not work properly if the system BIOS has been set to disable operating system control of power management.

Включить статические разгрузки.Enable static offloads. Например, включите контрольные суммы UDP, контрольные суммы TCP и отправку параметров большой разгрузки (LSO).For example, enable the UDP Checksums, TCP Checksums, and Send Large Offload (LSO) settings.

Если трафик проходит через несколько потоков, например при получении многоуровневого трафика многоадресной рассылки, включите RSS.If the traffic is multi-streamed, such as when receiving high-volume multicast traffic, enable RSS.

Отключите Управление прерываниями в драйверах сетевых адаптеров, которым требуется самая низкая задержка.Disable the Interrupt Moderation setting for network card drivers that require the lowest possible latency. Помните, что эта конфигурация может использовать больше времени ЦП и представляет компромисс.Remember, this configuration can use more CPU time and it represents a tradeoff.

Обрабатывайте прерывания сетевого адаптера и DPC на основном процессоре, который совместно использует процессорный кэш с ядром, которое используется программой (пользовательским потоком), обрабатывающей пакет.Handle network adapter interrupts and DPCs on a core processor that shares CPU cache with the core that is being used by the program (user thread) that is handling the packet. Для передачи процесса конкретным логическим процессорам можно использовать настройку фиксации ЦП вместе с настройкой RSS.CPU affinity tuning can be used to direct a process to certain logical processors in conjunction with RSS configuration to accomplish this. Использование одного ядра для прерываний, DPC и пользовательского потока ведет к снижению производительности из-за увеличения нагрузки, поскольку ISR, DPC и поток будут конкурировать за ядро.Using the same core for the interrupt, DPC, and user mode thread exhibits worse performance as load increases because the ISR, DPC, and thread contend for the use of the core.

Прерывания управления системойSystem management interrupts

Многие аппаратные системы используют прерывания управления системой (SMI) для различных функций обслуживания, таких как сообщения об ошибках с кодом коррекции ошибок (ECC), поддержка устаревшей совместимости с USB, управление вентилятором и управление питанием, управляемым BIOS Параметры.Many hardware systems use System Management Interrupts (SMI) for a variety of maintenance functions, such as reporting error correction code (ECC) memory errors, maintaining legacy USB compatibility, controlling the fan, and managing BIOS-controlled power settings.

SMI — это прерывание с наивысшим приоритетом в системе и помещает ЦП в режим управления.The SMI is the highest-priority interrupt on the system, and places the CPU in a management mode. Этот режим загружает все остальные действия, в то время как SMI запускает подпрограммы службы прерываний, обычно содержащиеся в BIOS.This mode preempts all other activity while SMI runs an interrupt service routine, typically contained in BIOS.

К сожалению, такое поведение может привести к скачкам задержки 100 микросекунд или более.Unfortunately, this behavior can result in latency spikes of 100 microseconds or more.

Когда необходимо обеспечить минимальную задержку, следует запросить у поставщика оборудования версию BIOS, в которой прерывания SMI имеют наименьший возможный приоритет.If you need to achieve the lowest latency, you should request a BIOS version from your hardware provider that reduces SMIs to the lowest degree possible. Эти версии BIOS часто называются "BIOS с низкой задержкой" или "SMI Free BIOS".These BIOS versions are frequently referred to as "low latency BIOS" or "SMI free BIOS." В некоторых случаях аппаратная платформа не может полностью устранить операции SMI, поскольку они используются для управления важными функциями (например для вентиляторов).In some cases, it is not possible for a hardware platform to eliminate SMI activity altogether because it is used to control essential functions (for example, cooling fans).

Примечание

Операционная система не может управлять SMIs, так как логический процессор работает в специальном режиме обслуживания, что предотвращает вмешательство пользователя операционной системы.The operating system cannot control SMIs because the logical processor is running in a special maintenance mode, which prevents operating system intervention.

Настройка производительности TCPPerformance tuning TCP

Для настройки производительности TCP можно использовать следующие элементы.You can use the following items to tune TCP performance.

Автоматическая настройка окна приема TCPTCP receive window autotuning

В Windows Vista, Windows Server 2008 и более поздних версиях в сетевом стеке Windows для согласования размера окна приема TCP используется функция, называемая режимом автонастройки окна приема TCP.In Windows Vista, Windows Server 2008, and later versions of Windows, the Windows network stack uses a feature that is named TCP receive window autotuning level to negotiate the TCP receive window size. Эта функция может согласовать определенный размер окна приема для каждого подключения TCP во время подтверждения TCP.This feature can negotiate a defined receive window size for every TCP communication during the TCP Handshake.

В более ранних версиях Windows сетевой стек Windows использовал окно приема фиксированного размера (65 535 байт), которое ограничивает общую возможную пропускную способность для подключений.In earlier versions of Windows, the Windows network stack used a fixed-size receive window (65,535 bytes) that limited the overall potential throughput for connections. Общая пропускная способность подключений TCP может ограничивать сценарии использования сети.The total achievable throughput of TCP connections could limit network usage scenarios. Автоматическая настройка окна приема TCP позволяет этим сценариям полностью использовать сеть.TCP receive window autotuning enables these scenarios to fully use the network.

Для окна приема TCP, имеющего определенный размер, можно использовать следующее уравнение для вычисления общей пропускной способности отдельного соединения.For a TCP receive window that has a particular size, you can use the following equation to calculate the total throughput of a single connection.

Общая пропускная способность в байтах = Размер окна приема TCP в байтах * (1/ Задержка подключения в секундах)Total achievable throughput in bytes = TCP receive window size in bytes * (1 / connection latency in seconds)

Например, для соединения с задержкой 10 мс общая пропускная способность составляет только 51 Мбит/с.For example, for a connection that has a latency of 10 ms, the total achievable throughput is only 51 Mbps. Это значение целесообразно для большой корпоративной сетевой инфраструктуры.This value is reasonable for a large corporate network infrastructure. Однако с помощью автонастройки для настройки окна приема подключение может обеспечить полную скорость линии для подключения 1 Гбит/с.However, by using autotuning to adjust the receive window, the connection can achieve the full line rate of a 1-Gbps connection.

Некоторые приложения определяют размер окна приема TCP.Some applications define the size of the TCP receive window. Если приложение не определяет размер окна приема, скорость связи определяется следующим образом:If the application does not define the receive window size, the link speed determines the size as follows:

- Менее 1 мегабит в секунду (Мбит/с): 8 килобайт (КБ)Less than 1 megabit per second (Mbps): 8 kilobytes (KB)

- от 1 Мбит/с до 100 Мбит/с: 17 КБ1 Mbps to 100 Mbps: 17 KB

- от 100 Мбит/с до 10 гигабит в секунду (Гбит/с): 64 КБ100 Mbps to 10 gigabits per second (Gbps): 64 KB

- 10 Гбит/с или более: 128 КБ10 Gbps or faster: 128 KB

Например, на компьютере с установленным сетевым адаптером с 1 Гбит/с размер окна должен быть 64 КБ.For example, on a computer that has a 1-Gbps network adapter installed, the window size should be 64 KB.

Эта функция также обеспечивает полное использование других функций для повышения производительности сети.This feature also makes full use of other features to improve network performance. Эти функции включают остальные параметры TCP, определенные в RFC 1323.These features include the rest of the TCP options that are defined in RFC 1323. С помощью этих функций компьютеры под управлением Windows могут согласовать размеры окна приема TCP, которые меньше, но масштабируются по определенному значению в зависимости от конфигурации.By using these features, Windows-based computers can negotiate TCP receive window sizes that are smaller but are scaled at a defined value, depending on the configuration. Такое поведение упрощает обработку размеров для сетевых устройств.This behavior the sizes easier to handle for networking devices.

Примечание

Может возникнуть проблема, при которой сетевое устройство не соответствует параметру TCP Window Scale, как определено в RFC 1323 и, следовательно, не поддерживает коэффициент масштабирования.You may experience an issue in which the network device is not compliant with the TCP window scale option, as defined in RFC 1323 and, therefore, doesn't support the scale factor. В таких случаях см. статью KB 934430, сетевое подключение завершается сбоем при попытке использовать Windows Vista за устройством брандмауэра или обратитесь в службу поддержки для поставщика сетевых устройств.In such cases, refer to this KB 934430, Network connectivity fails when you try to use Windows Vista behind a firewall device or contact the Support team for your network device vendor.

Проверка и настройка уровня автонастройки окна приема TCPReview and configure TCP receive window autotuning level

Для просмотра или изменения уровня автонастройки окна приема TCP можно использовать команды netsh или командлеты Windows PowerShell.You can use either netsh commands or Windows PowerShell cmdlets to review or modify the TCP receive window autotuning level.

Примечание

В отличие от версий Windows, предшествующих Windows 10 или Windows Server 2019, вы больше не можете использовать реестр для настройки размера окна приема TCP.Unlike in versions of Windows that pre-date Windows 10 or Windows Server 2019, you can no longer use the registry to configure the TCP receive window size. Дополнительные сведения об устаревших параметрах TCPсм. здесь.For more information about the deprecated settings, see Deprecated TCP parameters.

Использование команды Netsh для просмотра или изменения уровня автонастройкиTo use netsh to review or modify the autotuning level

Чтобы проверить текущие параметры, откройте окно командной строки и выполните следующую команду:To review the current settings, open a Command Prompt window and run the following command:

netsh interface tcp show global Выходные данные этой команды должны выглядеть следующим образом:The output of this command should resemble the following:

Querying active state... TCP Global Parameters ----- Receive-Side Scaling State : enabled Chimney Offload State : disabled Receive Window Auto-Tuning Level : normal Add-On Congestion Control Provider : default ECN Capability : disabled RFC 1323 Timestamps : disabled Initial RTO : 3000 Receive Segment Coalescing State : enabled Non Sack Rtt Resiliency : disabled Max SYN Retransmissions : 2 Fast Open : enabled Fast Open Fallback : enabled Pacing Profile : off Чтобы изменить этот параметр, выполните в командной строке следующую команду:To modify the setting, run the following command at the command prompt:

netsh interface tcp set global autotuninglevel=<Value> Примечание

В предыдущей команде <значение> представляет новое значение для уровня автоматической настройки.In the preceding command, <Value> represents the new value for the auto tuning level.

Дополнительные сведения об этой команде см. в разделе команды Netsh для протокола управления передачей интерфейса.For more information about this command, see Netsh commands for Interface Transmission Control Protocol.

Использование PowerShell для просмотра или изменения уровня автонастройкиTo use Powershell to review or modify the autotuning level

Чтобы проверить текущие параметры, откройте окно PowerShell и выполните следующий командлет.To review the current settings, open a PowerShell window and run the following cmdlet.

Get-NetTCPSetting | Select SettingName,AutoTuningLevelLocal Выходные данные этого командлета должны выглядеть следующим образом.The output of this cmdlet should resemble the following.

SettingName AutoTuningLevelLocal ----------- -------------------- Automatic InternetCustom Normal DatacenterCustom Normal Compat Normal Datacenter Normal Internet Normal Чтобы изменить этот параметр, выполните следующий командлет в командной строке PowerShell.To modify the setting, run the following cmdlet at the PowerShell command prompt.

Set-NetTCPSetting -AutoTuningLevelLocal <Value> Примечание

В предыдущей команде <значение> представляет новое значение для уровня автоматической настройки.In the preceding command, <Value> represents the new value for the auto tuning level.

Дополнительные сведения об этих командлетах см. в следующих статьях:For more information about these cmdlets, see the following articles:

Уровни автонастройкиAutotuning levels

Можно настроить автоматическую настройку окна приема на любой из пяти уровней.You can set receive window autotuning to any of five levels. Уровень по умолчанию — Обычная.The default level is Normal. В следующей таблице описаны уровни.The following table describes the levels.

| УровеньLevel | Шестнадцатеричное значениеHexadecimal value | CommentsComments |

|---|---|---|

| Normal (по умолчанию)Normal (default) | 0x8 (коэффициент масштабирования 8)0x8 (scale factor of 8) | Задайте для окна приема TCP значение рост в соответствии с практически всеми сценариями.Set the TCP receive window to grow to accommodate almost all scenarios. |

| Отключено.Disabled | Коэффициент масштабирования недоступенNo scale factor available | Задайте для окна приема TCP значение по умолчанию.Set the TCP receive window at its default value. |

| Restricted (Ограничено)Restricted | 0x4 (коэффициент масштабирования 4)0x4 (scale factor of 4) | Задайте размер окна приема TCP, превышающего значение по умолчанию, но ограничьте такой рост в некоторых сценариях.Set the TCP receive window to grow beyond its default value, but limit such growth in some scenarios. |

| С высоким уровнем ограниченийHighly Restricted | 0x2 (коэффициент масштабирования 2)0x2 (scale factor of 2) | Задайте размер окна приема TCP, превышающего значение по умолчанию, но это очень консервативно.Set the TCP receive window to grow beyond its default value, but do so very conservatively. |

| ПробExperimental | 0xE (коэффициент масштабирования 14)0xE (scale factor of 14) | Задайте для окна приема TCP значение рост в соответствии с экстремальными сценариями.Set the TCP receive window to grow to accommodate extreme scenarios. |

Если для записи сетевых пакетов используется приложение, приложение должно сообщить данные, аналогичные приведенным ниже, для различных параметров автонастройки окна.If you use an application to capture network packets, the application should report data that resembles the following for different window autotuning level settings.

Уровень автонастройки: нормальный (состояние по умолчанию)Autotuning level: Normal (default state)

Frame: Number = 492, Captured Frame Length = 66, MediaType = ETHERNET + Ethernet: Etype = Internet IP (IPv4),DestinationAddress:[D8-FE-E3-65-F3-FD],SourceAddress:[C8-5B-76-7D-FA-7F] + Ipv4: Src = 192.169.0.5, Dest = 192.169.0.4, Next Protocol = TCP, Packet ID = 2667, Total IP Length = 52 - Tcp: [Bad CheckSum]Flags=......S., SrcPort=60975, DstPort=Microsoft-DS(445), PayloadLen=0, Seq=4075590425, Ack=0, Win=64240 ( Negotiating scale factor 0x8 ) = 64240 SrcPort: 60975 DstPort: Microsoft-DS(445) SequenceNumber: 4075590425 (0xF2EC9319) AcknowledgementNumber: 0 (0x0) + DataOffset: 128 (0x80) + Flags: ......S. ---------------------------------------------------------> SYN Flag set Window: 64240 ( Negotiating scale factor 0x8 ) = 64240 ---------> TCP Receive Window set as 64K as per NIC Link bitrate. Note it shows the 0x8 Scale Factor. Checksum: 0x8182, Bad UrgentPointer: 0 (0x0) - TCPOptions: + MaxSegmentSize: 1 + NoOption: + WindowsScaleFactor: ShiftCount: 8 -----------------------------> Scale factor, defined by AutoTuningLevel + NoOption: + NoOption: + SACKPermitted:Уровень автонастройки: отключенAutotuning level: Disabled

Frame: Number = 353, Captured Frame Length = 62, MediaType = ETHERNET + Ethernet: Etype = Internet IP (IPv4),DestinationAddress:[D8-FE-E3-65-F3-FD],SourceAddress:[C8-5B-76-7D-FA-7F] + Ipv4: Src = 192.169.0.5, Dest = 192.169.0.4, Next Protocol = TCP, Packet ID = 2576, Total IP Length = 48 - Tcp: [Bad CheckSum]Flags=......S., SrcPort=60956, DstPort=Microsoft-DS(445), PayloadLen=0, Seq=2315885330, Ack=0, Win=64240 ( ) = 64240 SrcPort: 60956 DstPort: Microsoft-DS(445) SequenceNumber: 2315885330 (0x8A099B12) AcknowledgementNumber: 0 (0x0) + DataOffset: 112 (0x70) + Flags: ......S. ---------------------------------------------------------> SYN Flag set Window: 64240 ( ) = 64240 ----------------------------------------> TCP Receive Window set as 64K as per NIC Link bitrate. Note there is no Scale Factor defined. In this case, Scale factor is not being sent as a TCP Option, so it will not be used by Windows. Checksum: 0x817E, Bad UrgentPointer: 0 (0x0) - TCPOptions: + MaxSegmentSize: 1 + NoOption: + NoOption: + SACKPermitted:Уровень автонастройки: ограниченныйAutotuning level: Restricted

Frame: Number = 3, Captured Frame Length = 66, MediaType = ETHERNET + Ethernet: Etype = Internet IP (IPv4),DestinationAddress:[D8-FE-E3-65-F3-FD],SourceAddress:[C8-5B-76-7D-FA-7F] + Ipv4: Src = 192.169.0.5, Dest = 192.169.0.4, Next Protocol = TCP, Packet ID = 2319, Total IP Length = 52 - Tcp: [Bad CheckSum]Flags=......S., SrcPort=60890, DstPort=Microsoft-DS(445), PayloadLen=0, Seq=1966088568, Ack=0, Win=64240 ( Negotiating scale factor 0x4 ) = 64240 SrcPort: 60890 DstPort: Microsoft-DS(445) SequenceNumber: 1966088568 (0x75302178) AcknowledgementNumber: 0 (0x0) + DataOffset: 128 (0x80) + Flags: ......S. ---------------------------------------------------------> SYN Flag set Window: 64240 ( Negotiating scale factor 0x4 ) = 64240 ---------> TCP Receive Window set as 64K as per NIC Link bitrate. Note it shows the 0x4 Scale Factor. Checksum: 0x8182, Bad UrgentPointer: 0 (0x0) - TCPOptions: + MaxSegmentSize: 1 + NoOption: + WindowsScaleFactor: ShiftCount: 4 -------------------------------> Scale factor, defined by AutoTuningLevel. + NoOption: + NoOption: + SACKPermitted:Уровень автонастройки: очень ограниченныйAutotuning level: Highly restricted

Frame: Number = 115, Captured Frame Length = 66, MediaType = ETHERNET + Ethernet: Etype = Internet IP (IPv4),DestinationAddress:[D8-FE-E3-65-F3-FD],SourceAddress:[C8-5B-76-7D-FA-7F] + Ipv4: Src = 192.169.0.5, Dest = 192.169.0.4, Next Protocol = TCP, Packet ID = 2388, Total IP Length = 52 - Tcp: [Bad CheckSum]Flags=......S., SrcPort=60903, DstPort=Microsoft-DS(445), PayloadLen=0, Seq=1463725706, Ack=0, Win=64240 ( Negotiating scale factor 0x2 ) = 64240 SrcPort: 60903 DstPort: Microsoft-DS(445) SequenceNumber: 1463725706 (0x573EAE8A) AcknowledgementNumber: 0 (0x0) + DataOffset: 128 (0x80) + Flags: ......S. ---------------------------------------------------------> SYN Flag set Window: 64240 ( Negotiating scale factor 0x2 ) = 64240 ---------> TCP Receive Window set as 64K as per NIC Link bitrate. Note it shows the 0x2 Scale Factor. Checksum: 0x8182, Bad UrgentPointer: 0 (0x0) - TCPOptions: + MaxSegmentSize: 1 + NoOption: + WindowsScaleFactor: ShiftCount: 2 ------------------------------> Scale factor, defined by AutoTuningLevel + NoOption: + NoOption: + SACKPermitted:Уровень автонастройки: экспериментальныйAutotuning level: Experimental

Frame: Number = 238, Captured Frame Length = 66, MediaType = ETHERNET + Ethernet: Etype = Internet IP (IPv4),DestinationAddress:[D8-FE-E3-65-F3-FD],SourceAddress:[C8-5B-76-7D-FA-7F] + Ipv4: Src = 192.169.0.5, Dest = 192.169.0.4, Next Protocol = TCP, Packet ID = 2490, Total IP Length = 52 - Tcp: [Bad CheckSum]Flags=......S., SrcPort=60933, DstPort=Microsoft-DS(445), PayloadLen=0, Seq=2095111365, Ack=0, Win=64240 ( Negotiating scale factor 0xe ) = 64240 SrcPort: 60933 DstPort: Microsoft-DS(445) SequenceNumber: 2095111365 (0x7CE0DCC5) AcknowledgementNumber: 0 (0x0) + DataOffset: 128 (0x80) + Flags: ......S. ---------------------------------------------------------> SYN Flag set Window: 64240 ( Negotiating scale factor 0xe ) = 64240 ---------> TCP Receive Window set as 64K as per NIC Link bitrate. Note it shows the 0xe Scale Factor. Checksum: 0x8182, Bad UrgentPointer: 0 (0x0) - TCPOptions: + MaxSegmentSize: 1 + NoOption: + WindowsScaleFactor: ShiftCount: 14 -----------------------------> Scale factor, defined by AutoTuningLevel + NoOption: + NoOption: + SACKPermitted:

Устаревшие параметры TCPDeprecated TCP parameters

Следующие параметры реестра из Windows Server 2003 больше не поддерживаются и не учитываются в более поздних версиях.The following registry settings from Windows Server 2003 are no longer supported, and are ignored in later versions.

- TcpWindowSizeTcpWindowSize

- нумткбтаблепартитионсNumTcbTablePartitions

- максхаштаблесизеMaxHashTableSize

Все эти параметры были расположены в следующем подразделе реестра:All of these settings were located in the following registry subkey:

HKEY_LOCAL_MACHINE \Систем\куррентконтролсет\сервицес\ткпип\параметерсHKEY_LOCAL_MACHINE\System\CurrentControlSet\Services\Tcpip\Parameters

Платформа фильтрации WindowsWindows Filtering Platform

В Windows Vista и Windows Server 2008 появилась платформа фильтрации Windows (WFP).Windows Vista and Windows Server 2008 introduced the Windows Filtering Platform (WFP). WFP предоставляет интерфейсы API независимым поставщикам программного обеспечения (ISV) для создания фильтров обработки пакетов.WFP provides APIs to non-Microsoft independent software vendors (ISVs) to create packet processing filters. Например, для брандмауэров и антивирусного ПО.Examples include firewall and antivirus software.

Ссылки на все разделы данного руководства см. в разделе Настройка производительности сетевой подсистемы.For links to all topics in this guide, see Network Subsystem Performance Tuning.

Настройка сетевого адаптера для улучшения интернета

Иногда при подключении интернета или использовании ресурсов локальной сети возникают проблемы. Могут вылезать ошибки подключения, получения IP адресов или конфигурации сетевого оборудования. Внутри компьютера или ноутбука, функцией подключения к локальной или глобальной сети, занимается сетевой адаптер. В статье мы как раз и поговорим про настройку сетевого адаптера для улучшения связи в интернете. Инструкция будет ходовая для всех версий Windows 7, 8 и 10.

Более подробная настройка

Мне постоянно приходят письма с вопросами – как более детально настроить сетевой адаптер для меньшего пинга в играх, для лучшего просмотра кино и большей скорости скачивания. Поэтому я решил написать более детальную статью. Ну, поехали! По идее она настраивается автоматически под рациональное использование ресурсов системы и самого устройства. Но конфигурацию можно корректировать под свои нужды.

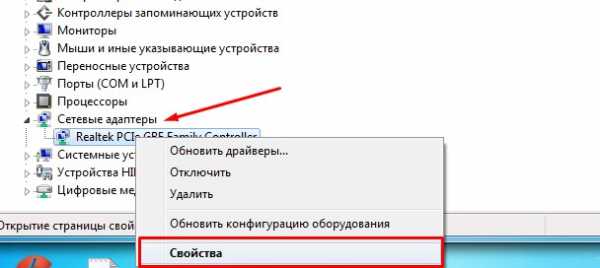

И так нажимаем одновременно на клавишу «R» и «WIN». Далее прописываем «mmc devmgmt.msc» и жмём «ОК». Теперь находим раздел «Сетевые адаптеры» и далее переходим в свойства того устройства, который вы хотите настроить.

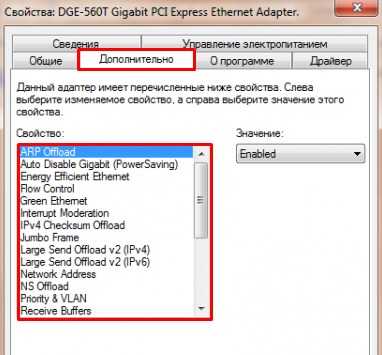

Переходим во вкладку «Дополнительно». И так смотрите, у нас есть определённые свойства, которые мы можем включать (Enebled) или выключать (Disable). На новых версиях «Виндовс» может быть написано «Вкл» или «Выкл». А теперь разбёрем каждое свойство:

ВНИМАНИЕ! Параметры адаптера могут в какой-то степени улучшить показатели, в каком-то моменте ухудшить. Изменяя установки сетевого адаптера, лучше возьмите листочек и выпишите – что именно вы изменили, чтобы в случаи чего вернуть параметры обратно. Также я рекомендую скачать последнюю версию драйвера для вашей сетевой карты или Wi-Fi модуля и установить его. Только после этого заходим в характеристики

- ARP Offload – данная функция включена автоматом. Позволяет игнорировать все ARP запросы. Нужна в качестве защиты. Но иногда в некоторых организациях ее включают для более детальной настройки сети.

- Large Send Offload IPv4/IPv6 – Giant Send Offload – функция перекладывает фрагментацию пакетов именно на адаптер. Включаем обязательно, чтобы снизить нагрузку на центральный процессор.

- Auto Disable Gigabit – если у вас роутер или коммутатор подключен с 4 жилами – 100 Мбит в секунду, то выключаем эту функцию. Она включает и отключает поддержку 1 Гбита. Если вы пользуетесь кабелями по 100 Мбит её можно также отключить. Для роутеров с портом на 1 Гбит – включаем.

- Energy Efficient Ethernet – включает энергосбережение – можно включить на ноутбуках, но если скорость станет ниже или будут проблемы с интернетом – сразу выключаем. Для игроманов – вообще ничего по энергосбережению включать не нужно, так как при этом будет сильно садиться показатель производительности обработки сетевого трафика.

- Flow Control – если пакеты данных не успели обработаться они стают в очереди. При этом на сервер отсылается команда, чтобы он подождал с отправкой данных. Так как если будет переполнен буфер памяти сетевой карты, информация может потеряться. В общем если сильные лаги, тормоза при просмотре видео – можете включить.

- Network Address – виртуальный МАК-адрес. Можно поменять, но бессмысленно, так как физический МАК остается. Этот пункт игнорируем.

- TCP/UDP Checksum Offload IPv4/IPv6 (контрольная сумма) – для обработки контрольной суммы будет выступать процессор, а не сетевая карта. Нужно включать, если есть интенсивная передача пакетов. Опять же для игр может уменьшить нагрузку на сетевую карту и уменьшить лаги. (Rx & Tx Включить)

- Transmit Buffers — это как раз тот самый буфер. Если будет сильно маленькое значение могут быть лаги в играх, так что лучше выставить значение по умолчанию – 147.

- Green Ethernet – опять сокращение энергопотребление, на ПК эту функцию лучше выключить. На ноутбуках – по ситуации.

- TCP Checksum Offload (IPv4)/ (IPv6) – Та же контрольная сумма, но для TCP. Ставим в режим «Вкл».

- Interrupt Moderation – если много качаете, включите. Если много играете, может повышать пинг в игре, из-за простоя пакетов – тогда вырубаем.

- Receive Side Scaling – RSS – для обработки нескольких потоков сразу всеми свободными ядрами процессора. Нужно для многоядерных процессоров. Если функция выключена, то все потоки по очереди будут обрабатываться одним ядром. В общем будут лаги и прерывания. Если при включении вы видите, что стало ещё хуже, значит нужно обновить драйвер на адаптер. Качаем только с официального сайта. Вообще это свойство обязательно включается по умолчанию.

- Priority & VLAN – при отправке пакета дополнительно записываем информацию, о важности и приоритете пакета. Можно включить. Если будут лаги и тормоза – выключаем.

- WOL & Shutdown Link Speed – стандартная скорость коннекта при отключении. Ставим на сотку.

- NS Offload – Включаем. Таким образом соседские Wi-Fi сети при отправке запроса к вам, не будут получать ответа.

- Jumbo Frame – Jumbo Packet – я бы эту функцию выключил, так как она снижает частоту обработки пакетов в 6 раз.

- Speed & Duplex – выставляет режим в «Дуплекс» или «Полудуплекс». Первый позволяет одновременно принимать и отправлять данные – ставим, если играем. Второй режим может одновременно принимать или отправлять данные. Ставим второй, если много качаем. Но честно сказать, полудуплекс сильно снижает нормальную работу очень многих сервисов. Поэтому лучше всегда ставить или «Автосогласование» или «Дуплекс».

- Wake on pattern match и Wake on Magic Packet – включаем.

- UDP Checksum Offload (IPv6)/ (IPv4) – включает обработку контрольной суммы пакетов UDP. Включаем для обработки процессором, а не «сетевухой».

После изменения, следует перезагрузить компьютер или ноутбук, чтобы некоторые изменения вступили в силу. Установки сетевого адаптера всегда можно откатить обратно, самое главное не потеряйте тот листок с настройками.

ПРОСЬБА! Если я что-то не указал, или написал что-то не так – пишите смело в комментариях свои исправления или замечания, буду рад поучиться чему-то у своих читателей.

Настройка сетевого адаптера » Полезные советы по работе с компьютером и не только:)

Интернет - это лучшее изобретение человечества, он объединяет более 35% населения Земли, а также открывает неограниченные возможности для обучения, работы, отдыха и общения. В вашем компьютере он появляется при помощи сетевого адаптера, имеющего беспроводной(Wi-Fi) или проводной интерфейс. В этой статье я расскажу о настройке адаптера для подключения к сети.

Есть несколько типов подключения интернета:

- Телефонная линия

- DSL, кабельная сеть или электропроводка

- Мобильная связь (2G,3G,4G - LTE)

- Оптоволокно

- Спутниковый интернет

Каждый из них имеет свои специфические особенности, однако компьютер чаще всего подключается при помощи обычной витой пары - кабеля RJ-45, либо при помощи Wi-Fi соединения с роутером(который, в свою очередь, тоже работает через витую пару или USB-модем).

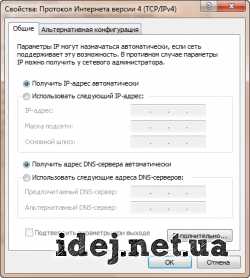

Настройка. Так как большинство пользователей использует Windows 7, то рассказывать я буду на ее примере.

Для этого мы переходим в Панель управления -> Сеть и Интернет -> Центр управления сетями и общим доступом, затем слева в меню выбираем Изменение параметров адаптера.

Здесь Вы можете увидеть список всех адаптеров компьютера и их статус подключения, включая Bluetooth-адаптеры, а также виртуальные адаптеры типа Hamachi.

Обычное подключение через витую пару(без роутеров, модемов)

Кабель "Витая пара" - RJ-45 - 8P8C

Тут также есть 2 варианта: Вам необходимо настроить соединение и каждый раз выполнять подключение либо Ваш провайдер поддерживает технологию DHCP и Вам просто необходимо воткнуть кабель в разьем.

В зависимости от Вашего варианта нужно правильно настроить адаптер.

Вариант 1

Заходим в список адаптеров. Выбираем нужный(Подключение по локальной сети ...) и нажимаем на нем правую клавишу мыши(ПКМ), здесь выбираем Свойства. В открывшемся списке выбираем компомнент Протокол Интернета версии 4 и нажимаем кнопку Свойства. Сюда необходимо вписать настройки, выданные Вашим оператором.

Вариант 2

Операция аналогичная Варианту 1, только в свойствах протокола необходимо установить флажки Получить IP-адрес автоматически, Получить адрес DNS-сервера автоматически.

Подключение при помощи роутера

Обычно роутер имеет 5 разьемов(4 LAN и 1 WAN). Кабель от интернета вы подключаете в WAN порт(он отделен от остальных), а затем при помощи второго кабеля/Wi-Fi адаптера соединяете роутер и компьютер. После этого (Смотрите Вариант 2 в подключении через витую пару), в адаптере Wi-Fi эти настройки стоят по-умолчанию.

Для последующей настройки интернета Вы заходите по локальному адресу роутера(192.168.0.1 или 192.168.1.1 - по-умолчанию) и выполняете необходимые действия.

Как настроить роутер Asus Вы можете прочитать в этой статье - https://idej.net/peripheral/44-kak-nastroit-router-asus.html

Остальные типы я расписывать не буду, все вопросы можете задать в комментариях.

Теперь детальнее о настройках адаптера

Чтобы увидеть эти настройки надо зайти в список адаптеров, нажать ПКМ на нужном адаптере, выбрать Свойства, затем под строкой с полным именем адаптера нажать кнопку Настроить. Здесь перейти на вкладку Дополнительно.

В основном, свойства одинаковы у всех адаптеров, однако все же есть небольшая разница.

Я буду рассказывать на примере D-Link DGE-560T.

Ниже будет таблица с указанием имени свойства и его описанием.

| Название свойства | Описание | Значения |

| ARP Offload - ARP Разгрузка | Функция позволяет не включать адаптер для ответа на ARP запрос(определение MAC-адреса по IP) | Disable - функция отключена. Enable - адаптер не включается для ответа на запрос. |

| Auto Disable Gigabit (Powersaving) - Автоотключение скорости в 1 Гбит/С | Функция энергосбережения - отключает гигабитную скорость при переподключении кабеля. | Disable - функция выключена. Re-Link, Battery - отключение при работе от батареи. Re-Link, Battery or AC - отключается всегда. |

| Energy Efficient Ethernet - Энергоэффективный интернет | Сокращение энергопотребления адаптера. | Disable - функция отключена. Enable - включено энергосбережение. |

| Flow Control - Управление потоком | Специальная технология притормаживания потока данных, если адаптер не успел обработать предыдущую информацию. Увеличивает быстродействие сети. | Disable - функция отключена. Enable - включено упр. потоком. |

| Green Ethernet - Зеленый интернет | Сокращение энергопотребления адаптера. | Disable - функция отключена. Enable - включено энергосбережение. |

| Interrupt Moderation - Координация прерываний | Технология, которая позволяет прерывать поток для обработки всего один раз вместо нескольких. Снижает нагрузку на ЦП. | Disable - функция отключена. Enable - включено упр. потоком. |

| IPv4 Checksum Offload - Контрольная сумма разгрузки IPv4 | Если опция включена, рассчитывание контрольной суммы файла при отправке(Tx) и принятии(Rx) выполняет сам адаптер. Снижает нагрузку на ЦП. | Disable - функция отключена. Rx Enabled - функция включена для принятия файлов. Tx Enabled - функция включена для отправки файлов. Rx & Tx Enabled - функция включена для отправки и принятия файлов. |

| Jumbo Frame - Большой кадр | Данная настройка увеличивает стандартный размер кадра передаваемых данных. Увеличивает быстродействие сети, когда большие кадры составляют основную часть трафика. | Disable - функция отключена. Стандратное значени. xKB MTU - функция включена, где X - длина большого кадра в КБ. |

| Large Send Offload v2 (IPv4) - Разгрузка при большой отправке (IPv4) | Включает функцию фрагментирования пакетов данных. Фрагментирование происходит за счет адаптера. Увеличивается быстродействие сети, снижается нагрузка на ЦП. | Disable - функция отключена. Enable - включено фрагментирование. |

| Large Send Offload v2 (IPv6) - Разгрузка при большой отправке (IPv6) | Все тоже самое, только для протокола IPv6. | Disable - функция отключена. Enable - включено фрагментирование. |

| Network Address - Сетевой адрес | Позволяет сменить виртуальный MAC-адрес устройства, аппаратный(физический) MAC-адрес не меняется. | Отсутствует - функция отключена. Значение - необходимо ввести нужный MAC-адрес. |

| NS Offload - NS разгрузка | Функция позволяет не включать адаптер для ответа на NS запрос(протокол обнаружения соседей). | Disable - функция отключена. Enable - адаптер не включается для ответа на запрос. |

| Priority & VLAN - Приоритет и VLAN | Помимо основной информации добавляет информацию о приоритете пакета и идентификатор VLAN в Ethernet-кадр. | Disable - запрещает аппаратное тегирование VLAN. Enable - разрешает аппаратное тегирование VLAN. |

| Receive Buffers - Буферы приема | Данное свойство задает кол-во буферов памяти при приеме адаптером какой-либо информации. При увеличении значения увеличивается производителсть адаптера, однако также увеличивается расход системной памяти. | Можно задать значения от 1 до ...(В зависимости от адаптера.У меня до 512). |

| Receive Side Scaling(RSS) - Получение бокового масштабирования | Механизм распределения нагрузки, при котором распределение пакетов TCP может происходить на нескольких ядрах CPU. | Disable - запрещает RSS. Enable - разрешает RSS. |

| Shutdown Wake-On-Lan(WOL) - Включение по локальной сети после отключения | Разрешает или запрещает функцию включения компьютера по сети через адаптер. | Disable - запрещает WOL. Enable - разрешает WOL. |

| Speed & Duplex - Скорость и дуплекс | Позволяет выставить нужную скорость соединения и режим паралелльного приема\передачи данных. Дуплекс - устройство одновременно принимает и передает информацию. Полудуплекс - устройство либо передает, либо принимает информацию. | Auto Negotiation - автосогласование с сетевым устройством. 10/100Mbps / Half/Full Duplex, 1.0 Gbps/Full Duplex - Режимы работы. |

| TCP Checksum Offload (IPv4) - Контрольная сумма разгрузки TCP (IPv4) | Позволяет адаптеру проверять контрольную сумму для пакетов TCP.Увеличивается быстродействие сети, снижается нагрузка на ЦП. | Disable - функция отключена. Enable - включено фрагментирование. |

| TCP Checksum Offload (IPv6) - Контрольная сумма разгрузки TCP (IPv6) | Позволяет адаптеру проверять контрольную сумму для пакетов TCP.Увеличивается быстродействие сети, снижается нагрузка на ЦП. | Disable - функция отключена. Enable - включено фрагментирование. |

| Transmit Buffers - Буферы передачи | Данное свойство задает кол-во буферов памяти при передачи адаптером какой-либо информации. При увеличении значения увеличивается производителсть адаптера, однако также увеличивается расход системной памяти. | Можно задать значения от 1 до ...(В зависимости от адаптера.У меня до 128). |

| UDP Checksum Offload (IPv4) - Контрольная сумма разгрузки UDP (IPv4) | Позволяет адаптеру проверять контрольную сумму для пакетов UDP.Увеличивается быстродействие сети, снижается нагрузка на ЦП. | Disable - функция отключена. Enable - включено фрагментирование. |

| UDP Checksum Offload (IPv6) - Контрольная сумма разгрузки UDP (IPv6) | Позволяет адаптеру проверять контрольную сумму для пакетов UDP.Увеличивается быстродействие сети, снижается нагрузка на ЦП. | Disable - функция отключена. Enable - включено фрагментирование. |

| Wake on Magic Packet | Дополнительная настройка Wake-On-Lan | Disable - функция отключена. Enable - функция включена. |

| Wake on pattern match | Дополнительная настройка Wake-On-Lan | Disable - функция отключена. Enable - функция включена. |

| WOL & Shutdown Link Speed - Скорость при включении по локальной сети после отключения | Определяет начальную скорость соединения полсе Wake-On-Lan | 10Mbps First, 100Mbps First - устанавливает начальную скорость 10/100 Мбит/с |

У вас остались вопросы? Вы хотите дополнить статью? Вы заметили ошибку? Сообщите мне об этом ниже, я обязательно Вас услышу!

Если Вам помогла данная статья, то напишите об этом в комментариях. И не забывайте делиться статьей со своими друзьями в соц.сетях;)

Дополнительные настройки драйвера для серверных сетевых адаптеров...

Настройки на вкладке « Дополнительно » позволяют настроить, как адаптер управляет маркировкой пакетов QoS, крупными кадрами, разгрузкой и другими возможностями.

Эта страница не относится к адаптерам с названием Pro/10 . Дополнительные настройки для этих адаптеров см. в разделе « Расширенные настройки серверных сетевых адаптеров Intel® PRO/10GbE».

| Примечание |

|

Щелкните или тему, чтобы узнать подробности:

Управление потокомУправление потоком позволяет адаптерам генерировать или реагировать на кадры управления потоком, которые помогают регулировать сетевой трафик. Вы можете настроить управление потоком на вкладке « Параметры производительности» при установке Intel® PROSet для диспетчера устройств Windows.

Партнер по связыванию может стать перегруженным, если входящие кадры приходят быстрее, чем устройство может их обработать. Кадры отбрасываются до тех пор, пока не передается условие перегрузки. Механизм управления потоком устраняет эту проблему и исключает риск потери кадров.

Если возникает ситуация перегрузки, устройство генерирует кадр управления потоком. Перед повторной передачей партнеру-партнеру по передаче данных необходимо прекратить передачу данных.

| Примечание | Чтобы воспользоваться преимуществами адаптеров, партнеры по связи должны поддерживать фреймы управления потоком. |

| Используемый | ПРИЕМ и передача включены |

| Спектр | Отключено: управление потоком не осуществляется. Прием и передача включены: адаптер генерирует и реагирует на кадры управления потоком. RX включен: адаптер приостанавливает передачу данных, когда он получает кадр управления потоком от партнера по работе с каналом связи. TX включен: адаптер генерирует кадр управления потоком, когда его очередь Receive достигает заранее установленного ограничения. |

Разделение данных в верхней части позволяет адаптеру разделить информацию из входящего пакета таким образом, что ЦП не должен обрабатывать весь пакет. Это действие разбиения сокращает использование ЦП.

| Mac | Windows Server 2008 * |

| Используемый | Пользу |

| Спектр | Отключено, включено |

Контроль прерываний позволяет адаптеру умеренно отрывать работу.

При поступлении пакета адаптер генерирует прерывание, которое позволяет драйверу обрабатывать пакет. При увеличении скорости компоновки повышается количество прерываний, а также увеличивается использование ресурсов процессора. Это приводит к ухудшению производительности системы. Когда вы включите контроль прерываний, скорость прерываний ниже, а результат — выше производительность системы.

| Mac | Windows Server 2008 |

| Используемый | Пользу |

| Спектр | Отключено, включено |

Частота контроля прерываний устанавливает частоту, с которой контроллер является умеренным, или замедляет создание прерываний. Это помогает оптимизировать пропускную способность сети и использование ЦП. Значение по умолчанию (Адаптивное) регулирует частоту прерывания динамически, в зависимости от типа трафика и использования сети. Выбор другого параметра может повысить производительность сети и системы в некоторых конфигурациях. Вы можете настроить частоту контроля прерываний в разделе «Свойства: Параметры производительности» , если установлен Intel® PROSet для диспетчера устройств Windows.

Без контроля прерываний использование ресурсов процессора возрастает при увеличении скорости передачи данных, поскольку система должна обрабатывать большее количество прерываний. Благодаря управлению прерываниями сетевой драйвер накапливает прерывания и отправляют одно прерывание, а не серию прерываний. При повышении скорости передачи данных высокая скорость обработки данных может повысить производительность системы. При низкой скорости передачи данных более низкий уровень контроля прерываний является предпочтительным, так как отложенные прерывания вызывают задержки.

| Используемый | Средство |

| Спектр | Адаптивные, высокие, низкие, средние, Выкл. |

Разгрузка контрольной суммы IPv4 позволяет адаптеру проверять контрольную сумму TCP/IP на полученных пакетах (RX) и оценивать контрольную сумму по передаваемым пакетам (TX). Вы можете настроить отправку контрольной суммы IPv4 в разделе « варианты настройки разгрузки TCP/IP» в случае установки Intel® PROSet для диспетчера устройств Windows. Эта функция позволяет повысить производительность TCP/IP и сократить использование ЦП. При отключенном разгрузке операционная система вычисляет и проверяет контрольную сумму TCP/IP.

| Используемый | ПРИЕМ и передача включены |

| Спектр | Отключено, RX и TX включен, RX включен, TX включен |

Включает в себя большие возможности для пакетов TCP/IP. Когда большие пакеты занимают наибольшее количество трафика и могут допускать больше задержек, пакеты крупных размеров могут сократить загрузку ЦП и повысить эффективность работы в сети. Стандартный размер кадра Ethernet составляет 1514 байт, в то время как в крупных кадрах может содержаться 4088 или 9014 байт. Доступные настройки зависят от конкретного адаптера.

Пакеты крупных размеров можно использовать только в том случае, если устройства в сети поддерживают один и тот же размер кадра. При настройке крупных фреймов на других сетевых устройствах имейте в о том, что сетевые устройства рассчитывают крупные размеры фрейма по-другому. Некоторые устройства включают информацию о заголовках в размерах кадров, а другие — нет.

| Примечание | Адаптеры Intel не включают информацию о заголовках в размер кадра. |

| Используемый | Невозможно |

| Спектр | Отключено (1514), 4088 и 9014 байт (Установите переключатель в 4 байт выше для CRC, а 4 байта — при использовании виртуальных ЛС. или маркировка пакетов QoS) |

IPv4-разгрузка большого размера (IPv4) устанавливает адаптер, чтобы отгрузить задачу сегментации сообщений TCP в допустимые кадры Ethernet. Если на компьютере установлено Intel® PROSet для диспетчера устройств, можно настроить отгрузку больших приемов в свойствах « варианты разгрузки TCP/IP» .

Поскольку аппаратное обеспечение адаптера может завершить сегментацию данных гораздо быстрее, чем по операционной системе, эта функция может повысить производительность передачи данных. Кроме того, адаптер использует меньше ресурсов ЦП.

| Mac | Windows Server 2008 |

| Используемый | Пользу |

| Спектр | Отключено, включено |

Разгрузка большой отправки (IPv4) и разгрузка больших отправок (IPv6) позволяет адаптеру отгрузить задачу сегментации сообщений TCP в допустимые кадры Ethernet.

Поскольку аппаратное обеспечение адаптера может завершить сегментацию данных гораздо быстрее, чем по операционной системе, эта функция может повысить производительность передачи данных. Кроме того, адаптер использует меньше ресурсов ЦП.

| Mac | Windows Server 2008 |

| Используемый | Пользу |

| Спектр | Отключено, включено |

Локально администрируемый адрес переопределяет начальный MAC-адрес с помощью назначенного пользователем MAC-адреса. Чтобы ввести новый сетевой адрес, введите в это поле 12-значное шестнадцатеричное число.

| Используемый | Удаление |

| Спектр | 0000 0000 0001-FFFF FFFF FFFD Вызван

|

| Примечание | В команде Intel® PROSet использует одно из следующих:

Intel PROSet не использует адаптер ЛАА, если:

|

Регистрация события состояния связи позволяет регистрировать следующие изменения состояния связи в журнале системных событий:

- LINK_UP_CHANGE

Указывает, что адаптер установил ссылку. - LINK_DOWN_CHANGE

Указывает, что адаптер потерял связь. - LINK_DUPLEX_MISMATCH

Указывает на несоответствие дуплексов между адаптером и партнером по связи

Чтобы узнать о проблемах с подключением, перейдите на вкладку « скорость линии » и запустите диагностику. Вкладка «скорость линии» и средство диагностики доступны только в том случае, если установлена система Intel® PROSet для диспетчера устройств Windows.

Прерывания с низким уровнем задержекФункция прерывания с низким уровнем задержек позволяет адаптерам обходиться за прерывание и генерировать прерывание при поступлении определенных пакетов TCP. Затем система может обработать пакет быстрее. Некоторые приложения имеют более быстрый доступ к сетевым данным благодаря снижению задержек при работе с данными.

Intel PROSet для Windows Device Manager должен быть установлен с целью обеспечения конфигурации прерываний низкого уровня задержек. Вы можете настроить свойства прерываний низкого уровня задержек в свойствах « Параметры производительности ». Чтобы использовать прерывания с низким уровнем задержек, установите флажок « использовать прерывания низкого уровня задержек » и выберите один из следующих вариантов.

- Используйте для пакетов с флагом TCP ПШ: Любые входящие пакеты с флагом TCP ПШ инициируют мгновенное прерывание. На отправляющем устройстве устанавливается флаг ПШ.

- Использовать для этих TCP-портов: Каждый пакет, полученный на определенных портах, инициирует немедленное прерывание. Вы можете указать до восьми портов.

| Примечание | Если вы включите прерывания с низким уровнем задержек, можно увеличить загрузку процессора системы. |

Разгрузка TCP-сегментации позволяет адаптеру отгрузить задачу сегментации сообщений TCP в допустимые кадры Ethernet. Вы можете настроить разгрузку TCP-сегментации в свойствах « варианты разгрузки TCP/IP» , если установлено Intel® PROSet для диспетчера устройств Windows.

Поскольку аппаратное обеспечение адаптера выполняет сегментацию данных гораздо быстрее по сравнению с программным обеспечением операционной системы, эта функция может повысить производительность передачи данных. Кроме того, адаптер использует меньше ресурсов ЦП.

| Используемый | Вход |

| Спектр | Выкл., вкл. |

Приоритет и виртуальная ЛС позволяют отправлять и принимать промаркированные пакеты IEEE 802.3 AC, в том числе:

- Метки 802.1 p QoS (качество обслуживания) для пакетов с метками приоритета

- 802.1ные метки q для VLAN

Если эта функция включена, размеченные тегами пакеты используют настройки очередей, определенные определением уровня приоритета операционной системы. Приоритет & VLAN автоматически включается, когда вы устанавливаете виртуальную ЛС на вкладке VLAN. Запрещено отключать маркировку, поскольку для VLAN требуется маркировка.

| Примечание | Для настройки VLAN на сетевых адаптерах Intel® необходимо установить Intel® PROSet для Windows Device Manager и расширенные сетевые сервисы (ANS). |

| Используемый | Приоритет & VLAN включен |

| Спектр | Приоритет & VLAN отключен, приоритет & VLAN включен, приоритет включен, виртуальная ЛС активирована |

Устанавливает количество буферов приема, используемых адаптером при копировании данных в память. Увеличение этого значения может повысить производительность, но потребляет системную память. Вы можете настроить буферы приема в разделе «Свойства: Параметры производительности» , если установлен Intel® PROSet для диспетчера устройств Windows.

Вы можете увеличить количество буферов приема, если вы заметите значительное снижение производительности полученного трафика. Если при получении производительности не возникает проблемы, используйте настройки по умолчанию.

| Используемый | 512 |

| Спектр | 128 – 2048 при увеличении числа 64 |

Масштабирование на стороне приема (RSS) позволяет обрабатывать TCP-подключения по нескольким процессорам или ядрам процессора. Если адаптер не поддерживает RSS или если ваша операционная система не поддерживает его, Настройка RSS не отображается.

| Используемый | Пользу |

| Спектр | Отключено, включено |

Очереди масштабирования на стороне приема выделяют пространство очереди для буферизации транзакций между сетевым адаптером и процессором. Конфигурация очередей не поддерживается всеми адаптерами, поддерживающими RSS-канал. Количество поддерживаемых очередей варьируется в зависимости от адаптера и операционной системы. Вы можете использовать только настройки адаптера и операционной системы.

| Используемый | 2 очереди |

| Спектр | 1, 2 или 4 очереди |

Дополнительную информацию о масштабировании на стороне приема см. в руководстве пользователя .

Разгруженных контрольных сумм TCP (IPv4)Разгруженных контрольных сумм TCP и разгруженных контрольных сумм TCP (IPv6) позволяют адаптеру вычислять (TX) или проверять (RX) контрольную сумму TCP пакетов. Вы можете настроить отгрузку контрольных сумм TCP в свойствах « варианты разгрузки TCP/IP» , если установлена система Intel® PROSet для диспетчера устройств Windows. Эта функция может повысить производительность и сократить загрузку ЦП. С включенной разгрузкой адаптер вычисляет или проверяет контрольную сумму для операционной системы.

| Mac | Все для IPv4, Windows Server 2008 для IPv6 |

| Используемый | ПРИЕМ и передача включены |

| Спектр | Отключено, RX и TX включен, RX включен, TX включен |

Устанавливает количество буферов передачи, используемых адаптером при копировании данных в память. Увеличение этого значения может повысить производительность передачи данных, но также потребляет системную память. Вы можете настроить буферы передачи в разделе «Свойства: Параметры производительности» , если установлен Intel® PROSet для диспетчера устройств Windows.

Вы можете выбрать увеличение количества буферов передачи, если вы заметите значительное снижение производительности передаваемого трафика. Если производительность передачи данных не является проблемой, используйте настройки по умолчанию.

| Используемый | 512 |

| Спектр | 128 — 16384 с шагом в 64 |

Разгруженных контрольных сумм по протоколу UDP (IPv4) и разгруженных контрольных сумм UDP (IPv6) позволяют адаптеру вычислять (TX) или проверять (RX) контрольную сумму UDP для пакетов. Вы можете настроить отправку контрольных сумм UDP в свойствах « варианты разгрузки TCP/IP» в случае установки Intel® PROSet для диспетчера устройств Windows. Эта функция может повысить производительность и сократить загрузку ЦП. С включенной разгрузкой адаптер вычисляет или проверяет контрольную сумму для операционной системы.

| Используемый | ПРИЕМ и передача включены |

| Спектр | Отключено, RX и TX включен, RX включен, TX включен |

Компьютеры и Интернет

Я испытывал серьезные проблемы с производительностью сети в течение долгого времени и никогда не мог определить источник этих проблем. CS:GO была практически не играбельной, потому что вряд ли были когда-либо зарегистрированы в качестве таковых, хотя я был на 200% уверен, я справился с выстрелом в голову. И в последнее время в естественном отборе 2 (в ns2), атакуя врага не получилось его убить. Кто-то из команды разработчиков в ns2 и ТАВ в ns2 член клана (ТАВ DCDarkling) предложил проверить сетевую статистику игры (вы можете включить её в большинстве игр, открыв меню консоли в игре и с помощью команды “net_stats 1”, чтобы включить пакет статистики).

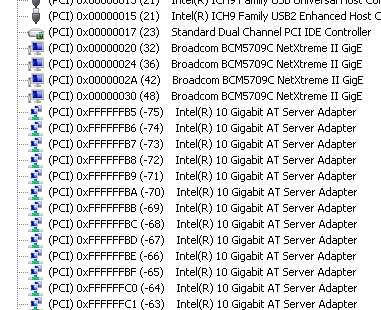

В статистике отобразилась большая потеря пакетов. И я придумал довольно простое решение без необходимости смены провайдера, так как изначально предложили другие люди. Я использую сетевую карту Intel LAN на моём ПК с чипсетом x99. И всё что я должен сделать, чтобы исправить проблемы было изменить дополнительные параметры для неё. Я помню такие же или аналогичные настройки на Marvell и контроллерах Realtek, поэтому вещи очень похожи.

Дело в том, что все эти технологии/настройки сетевых адаптеров обеспечивают надежность передачи данных за счет увеличения задержки. Что само по себе не является проблемой для обычных загрузок, но очень плохо для онлайн-игр. Ты не можешь исправить или изменить то, как игра ведет себя на сервере, но вы можете по крайней мере убедиться, что на стороне клиента (ваш компьютер) ведёт себя как можно лучше для игр. Я видел значительное улучшение, и работа может варьироваться в зависимости от многих других факторов, так что не ожидайте от этого руководства, что оно магически преодолеет старые медные соединения с вашим домом или плохо сделанную проводку интернета через Ваш дом.

Настройки сетевой карты в Windows 8.1 и Windows 10

Щёлкните правой кнопкой мыши на кнопку Пуск и выберите диспетчер устройств. Ищите Сетевые платы и дважды щелкните по ней. Щёлкните правой кнопкой мыши на сетевом адаптере, перечисленных в этой категории и выберите свойства. Нажмите на кнопку дополнительно.

Отключить адаптивный межкадровый интервала

Отключить все настройки энергосбережения (зеленый, eco, мощность и т. д.)

Отключить управление потоком

Отключить прерываниями

Набор прерываниями установить на off

Набор PME включить для гостей с ограниченными возможностями

Отключите все функции с помощью “Offload”

Отключите пакет приоритета и VLAN

Отключите пакеты

Большинство вариантов в этой категории для обеспечения надёжности, но вызывают задержку сетевого трафика, в результате игры по сети передают данные с опозданием, когда они уже должны были быть обработаны, это предполагает, что Вы сделали игру с которой никогда не случится замедление.

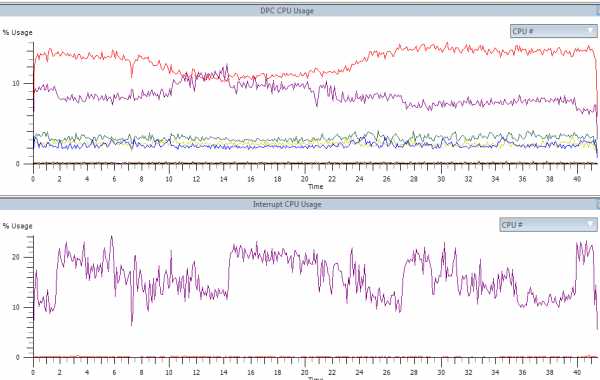

Набор буферов приема и передачи буферов до 96

В буфере соединения встречаются разные звери. Один из способов помочь предотвратить потерю данных, если данные не могут быть обработаны вовремя вашей системой, но имея данные в буферах значит будет задержка снова, прежде чем они на самом деле достигнут игрового движка (потому что данные сидят в буфере, ожидая, чтобы пройти через него). Если у вас действительно быстрая система, используя очень низкие значения позволит сократить задержки, потому что сетевой адаптер вынужден будет передавать их быстрее. С маломощной конечной системой это может привести к потере пакетов, так как сетевой адаптер будет просто удалять/отклонять пакеты, которые не вписываются в буферы.

Установить масштабирование на стороне приема (RSS-канал) включено

Установите количество очередей RSS на более высокое значение (2 в моем случае)

Масштабирование на стороне приема (RSS-канал) позволяет использовать несколько ядер процессора для обработки полученных сетевых пакетов быстрее и распространяя ЦП на количество ядер процессора. При включении этого раздела он будет обеспечивать и получать и передавать данные в буфер быстрее и буфер не будет переполнен данными, что позволяет установить очень низкое значение. Это может вызвать небольшие задержки ЦОД, потому что нескольким ядрам нужно синхронизировать сообщения между друг другом, но я думаю, что обработка будет быстрее и в целом помогает больше, чем немного выше будет задержка. Номер очереди RSS-канала определяет, сколько ядер процессора будут использоваться для обработки данных в сети. Значение 2 означает, что 2 из моих 6 ядер (процессор Intel 5820K) будут использованы для создания сети.

Результаты

После того, как я изменил настройки, в среднем я получил потери пакетов и они сократились с 10-12% до 0% (чего и тебе желаю!). Последовательность обработки также снизилась с 480 до 9 или 12 после того, как я поиграл в игру в течение нескольких минут. Это приемлемо, хотя я постараюсь, чтобы играть немного больше, чтобы сделать его ещё меньше, если это возможно.

Я также заметил что чтобы меня убить: коэффициент смертности (кд), значительно улучшился, а также меньше жалоб на то, что убить не получилось. Итак, попробуйте, если у вас ужасные проблемы с сетью как и у меня, вы не можете действительно сделать это хуже, чем есть.

Обратите внимание, что я не специалист в области сетевых технологий, все описанное выше – это то, что я узнал от чтения различных документов и мои прошлые знания о том, как компьютеры и сеть работают. Если у вас есть какие-то корректировки, расскажите, пожалуйста, внизу в комментариях и я буду обновлять информацию. Я также могу обновлять эту статью в будущем, если я смогу найти любую другую игру, в которой можно изменить настройки, которые её улучшат.